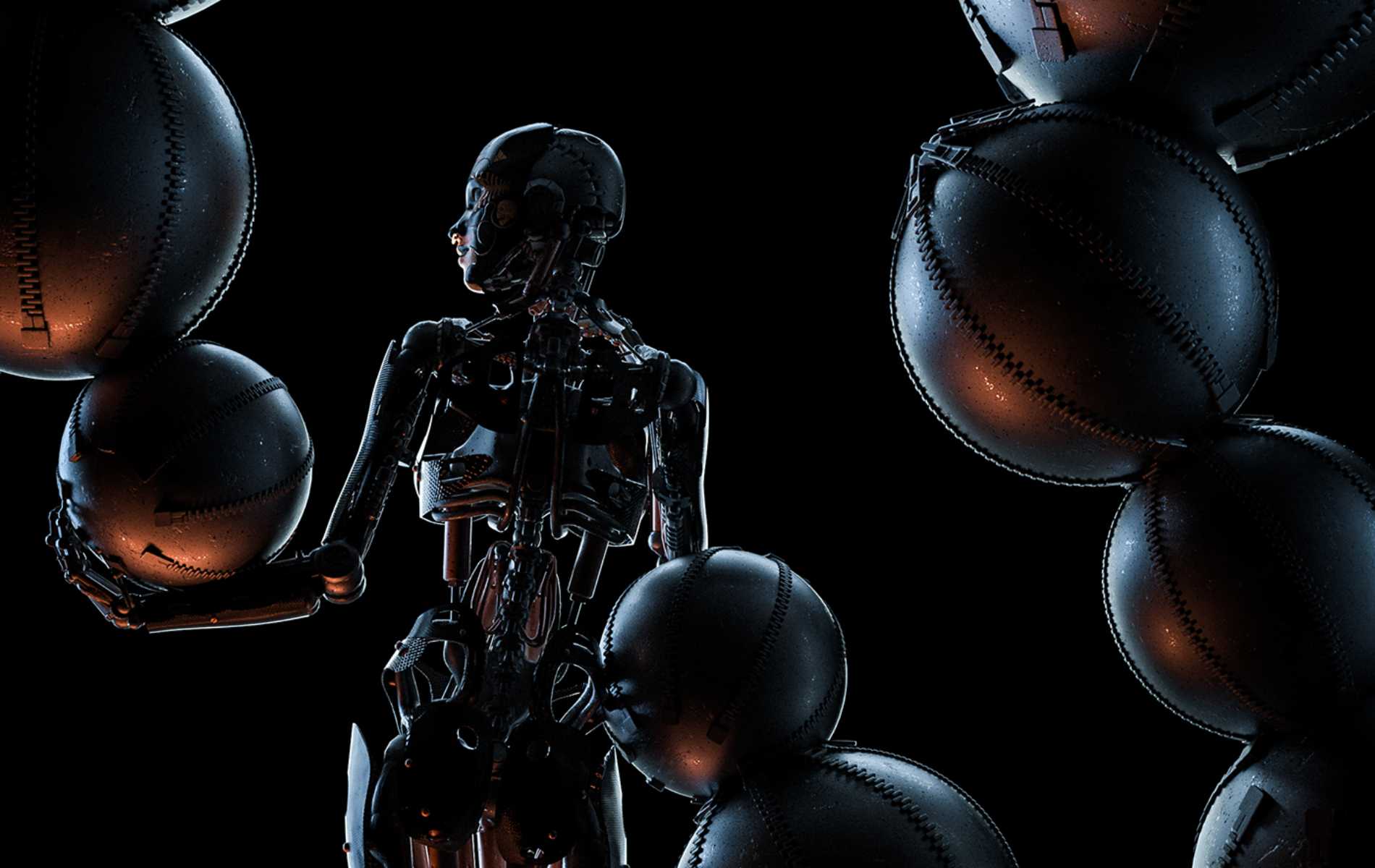

AI近30年遭遇莫拉维克悖论:困难问题易解;容易问题难解。

摩尔定律 & 莫拉维克悖论

尽管每个人都相信人有意识和自我意识,但是机器究竟有没有自我意识,能不能以及何时会发展出自我意识,是我们知之甚少也知之不确的问题。几乎所有的人工智能科幻电影都会告诉我们,机器终究会有一天产生自我觉知,会自我觉醒,与人类进行生存的智力竞赛。那么,为什么我们现在看到的机器行为却还不如一两岁的小孩子灵活?

人工智能技术领域有个尽人皆知的摩尔定律,即机器硬件性能每18-24个月会翻一番。但今天流行一种莫拉维克悖论。这是由机器人学家莫拉维克、布鲁克斯和人工智能开创者马文·明斯基提出来的。他们认为,机器依据已有规则做高阶推理、复杂计算、知识竞赛等事情,消耗的计算资源相对少一些,但让机器自如地应付环境以获得较强的感知和行为能力则需要消耗更多的资源。目前人工智能在实现某种弱人工智能的意义上已经超过了人类,特别是在超大型工程计算和工业机器人领域,甚至远远超过了人类智能。对那些需要长时计算的巨大算力,或者单靠人力不能完成的一些繁重和烦琐重复的工作,机器做得更快、更好。然而,让一个机器人像一个小孩子一样去感知外部世界并自由地应对环境却是非常困难的。1-2岁的小孩子具有非常好的处理环境信息的能力,能很好地平衡自己的身体以躲避危险,有非常灵活的感知行动能力和自适应能力。而且,运用这种能力时,小孩子是不需要什么逻辑推理和精心算计的。这是因为大量的感知行为能力是依赖许多默会知识、人类的情感以及一定的自我意识的。而默会知识和情感是很难算法化的,要机器像人类那样具有自我意识,就是更加难以想象的事情了。

可以说,今天的人工智能还没有摆脱“无心的机器”状态,这里的“心”英文是mind,有时译成“精神”,有时译成“心灵”或“心智”,其内涵非常丰富。实际上,人类心灵包括知觉、认知、行动控制和情绪情感多个层面。另外,人有心灵,是指我们有意识和意识体验,有自我觉知。单从功能和外部行为来看,今天的机器人能踢足球,能下棋,能演奏乐器,能作诗,能跳广场舞,能打太极拳,有表情,会说话,计算机程序甚至还是新闻写作、知识竞赛和玩难度超高游戏的高手。为什么我们还说机器人没有意识?下面我将逐一来分析“无心的机器”遭遇的几大困难。

谷歌翻译软件到底懂不懂英文与中文及其他语种之间的意义转换?目前看来,我们可以说它不懂。一度风靡全球的索菲亚看似可以自如地与人进行有表情的交流对话,但她的对答都是预定的某一种选择的结果。

困难一:机器不能理解符号的意义和物理世界的意义

机器不理解意义,不能主动建立与外部世界的关联并理解关联的意义,特别是机器不能理解人类语言的意义。

人类的内在世界与外部世界具有特定的意义关联,例如,我们内心的所思所想,多半都是有所指向的,指向外部世界的对象,也包括进行反思的内部对象。比如,“我想吃宁波小吃”这个愿望是有所指向的,就是指向“吃宁波小吃”,“吃宁波小吃”就是我心理欲望的内容。再如,“张三相信机器能超过人类”,那么“机器能超过人类”是张三“相信”的内容,是“张三相信”这种心理状态指向的东西。所以,人的心理活动指向的对象是与内部心理或外部世界有关联的,这个有所指向的关联属性在哲学中叫作“意向性”。但是,绝大多数人相信机器目前还不具有意向性。

由于经过几亿年生物演化和几百万年智人进化而来的人脑具有独特的构造,我们的心理状态自然地、自发地与外部世界建立起了一种意义关联。人能主动地不需要外界的动力就积极与环境进行互动,而且人对于这种主动性还有某种自我觉知:我不仅能觉知到我是当下这种头疼感受的体验者,而且是自己行动的自主发动者,如果需要,我会为自己的行动提供理由。这是目前机器所完全缺失的。

为什么我们能与外部世界建立这样的意义关联?另一种好的解释是,由于进化的结果,人与其他动物的一大区别是,人不仅能借助抽象符号进行思维,而且能用抽象的符号表达思想,在有了印刷术和更复杂的技术之后,人还能将思想印成书籍文字或制作成图像、音像及影像传播出去。事实上,人类在使用语言描述世界时,就与外部世界建构起了意义的关联,而且人是这种意义的制造者。动物当然也与外部世界有联系,借用自然之物为己所用。但是,人类会借助抽象符号,通过微妙的身体语言和人与人之间的话语交流,学习并共享知识,制造和使用人工造物(从简单的工具到复杂的机器)。重要的是,这些抽象符号背后是有语义的,人类成员能达到相互间的意义理解并掌握运用知识。

因此,我们需要进一步讨论以下问题:计算机程序有没有那种内在的自发的与世界的意义关联?计算机程序运行的符号的意义是自主产生的,还是机器设计者和人类程序员赋予的?如果计算机程序承载着人类抽象语言的语法结构,机器是否懂得人类语言所表达的意义?

最近10余年,我们看到,通过深度学习训练,多层人工神经网络可以执行各类特殊任务,但是我们也知道,在进行图像处理、语音处理,包括各种引擎搜索时,其所做的都是完成识别、搜索、过滤、匹配的任务,完全不涉及意义理解,其算法运行过程不过是某种函数的拟合而已。

例如,大家都感受到一代又一代新手机越来越智能了,而且语音输入很快就能转化成多语种的文字传输出去,相当于机器语音识别系统做了即时的语言翻译工作。那么,翻译过程中是不是包含理解语义的过程?谷歌翻译软件到底懂不懂英文与中文及其他语种之间的意义转换?目前看来,我们可以说它不懂。例如,风靡全球的索菲亚看似可以自如地与人进行有表情的交流对话,但她实际上不能真正理解人类语言,她的对答都是预定的某一种选择的结果。因此,自然语言意义理解的问题,仍然是目前人工智能难以解决的一大瓶颈问题,也被称作人工智能的“符号落地难题”。

要让机器与外部世界建立意义关联,主动地和包括人类在内的外部世界互动,做出值得人类信赖的行动,还需要机器具备理解物理世界与人类关系的能力。今天的机器,如无人驾驶汽车以及各种在物理环境中活动的机器人,其所作所为可以说与外部世界有所关联,但这不是建立在理解外部世界意义、理解人类意图的基础上,而只是在实现某种特殊的功能,它的行为是需要人类给予解释的。如果让波士顿动力公司的仿生机器大狗上战场,它根本不知道“战场”为何物,何为“敌人”,何为“战场上的危险”。因为“战场”也好,“敌我”也罢,都需要人类建构其语词的意义。如何与外部世界互动是人工智能的另一个瓶颈问题,被称作“物理落地难题”。因此,新近有人提出,图灵测试只在语言层面检验智能是不充分的,应该加入社会物理要素,修正快递机器人或老年护理机器人的物理测试标准。

在电影《我的女友是机器人》中,主人公花了60年时间,终于造出了一台有情感的机器人女友,这就隐喻着使机器有情感是件相当困难的事情。

困难二:机器没有意识和意识体验

人是一个生命有机体,这个生命体的独特之处在于他是有意识和意识体验的。例如,人除了有意向性,有信念、愿望、意图,会推理,能规划,还有喜怒哀乐、爱恨情仇,有疼痛的感觉,有沮丧无聊的情绪,有对他人的同情之心。显然机器目前完全没有这种意识和意识体验。比如,我正在一个坐满听众的讲堂做讲座时,看到光线照进来,讲堂里蓝色的椅子反射出不同的明暗,四周墙壁的色彩也非常柔和、具有立体感,再加上听众聚精会神地安静听讲,整个画面给我一种非常和谐的感觉。这种感觉就是一种意识体验。当我看到如此这般的色彩明暗,感受到画面的和谐时,我就产生了一种温馨惬意的感受,这就是我的意识体验的一部分。然而,如果换作另一个人站在这里,也许他与我会有完全不同的感受,这说明个体的意识体验是依赖主体的。一个人的痛觉、喜怒哀乐等情感都是独特的个体经验。一个人依据个人体验推及他人可能也会产生相似的体验,这就是同理之心。如果说今天的机器相当智能,那么,它们有没有类似的意识体验,有没有同理之心,懂不懂什么是和谐的感受?我们当然认为目前它们确实没有。与AlphaGo对弈时,有人说正是由于李世石情绪波动、焦虑输赢才被击败了,而AlphaGo始终镇定自若。那是因为AlphaGo没有意识体验,没有焦虑,没有喜也没有悲,根本不能体验输与赢的不同感受。在电影《我的女友是机器人》中,主人公花了60年时间,终于造出了一台有情感的机器人女友,这就隐喻着使机器有情感是件相当困难的事情。

那么,我们到底怎么才能把这样一种类似人类的意识和意识体验变成计算机程序,让人工智能实现有情感、有意识,可以和人类交流,使得未来人机共生的时代,人类与机器可以更好地相处呢?可以说,尽管现在很多专家在研究机器意识、机器情感,甚至尝试建造有情感、有意识体验的机器人,但是连他们自己也认为,离机器真正具有意识和情感还很遥远。

有人说AlphaGo当年下的那招臭棋是为了欺骗李世石,它真的会欺骗吗?它有没有一种欺骗他者的觉知,这当然是非常有意思的话题。

困难三:机器缺少自主性和自我觉知

今天的机器是没有自主性的,它们行为的驱动力并非来自内部。例如,在李世石与AlphaGo对弈时,如果拔了电源或中断网络,它的外部驱动力就没有了,也就没有了当下的智能。而人是有自主性的行动者,具有与外部世界积极互动的主观能动性。最重要的是,人有自由意志,在面对选择或需要采取行动时,无论是发自内心的愿望,还是经过各种利益权衡,我如何选择或如何采取行动,都是由我的独立意志决定的。当然,机器也会在各种备选答案中做出某种行为,但那终究是在算法和程序输入设定的选择空间中做出的选择。另外,人的行动大多是有动机和意图的,人会规划未来,想象未曾发生的事件,可以预测当未来情境与现实情况不同的时候应当采取什么行动。最重要的一点是,人是有自我觉知的,知道自己知道的,也知道自己行动的动机,可以为自己的行为提供辩护的理由。那么机器,比如AlphaGo走哪一步棋,它自己会不会为它的走子行为提供理由呢?有人说AlphaGo下的那招臭棋是为了欺骗李世石,它真的会欺骗吗?它有没有一种欺骗他者的觉知,这当然是非常有意思的话题。

当AlphaGo与李世石刚刚结束对战不久,我们就在中国人民大学专门开了一个人工智能与哲学的研讨会,讨论AlphaGo到底有什么智能,随后我在《光明日报》发表了一篇小文(见编者注),讲AlphaGo实际上是一个具有增强式集群智能的延展认知系统。下面我就从AlphaGo并不仅仅是一个单纯的算法或程序这个角度来分析一下机器的行为与有意识、有觉知的人类的行为究竟有何不同。实际上,AlphaGo是由走子网络、估值网络、快速走子程序和蒙特卡洛树搜索四大算法构成的一个算法系统操纵的。除此之外,人机大战现场的机器配备有1200个中央处理器和170个图形处理器,还装备了40个在线网络平台。云端大数据提供了历史上人类积累下来的3000万个棋谱,可以利用大数据搜索调取棋谱进行即时的高速信息处理。同时,为这场赛事还专门铺设了一条光缆。甚至参与设计和实施赛事的人员中还有一批年薪200万-300万美元的深度学习领域的世界顶级专家。

由此可见,这个大系统并不像大众所理解的只是一个下围棋的计算机程序,它实际上是一个人机交互的巨无霸耦合体,一个为处理围棋这个专项任务建构起来的延展认知系统。所谓延展,就是把个体大脑的思维和智力活动,经过与一些外部设备的关联延展到大脑之外,把很多智能任务卸载到机器上做功能处理,比如大数据、云计算、中央处理器、图形处理器,再把当前棋局与人类棋手依赖直觉、依赖经验或依赖知识积累的围棋招数比对,与3000万个棋谱进行匹配计算。所以,与李世石较量的AlphaGo,实际上是一个巨大的延展认知的智能系统。

那么,这个系统的智能到底是什么?我认为,这是一种包括了人的智能和机器智能的增强式的集群智能,一个人机交互系统的智能。在这个系统里,核心的还是人的意识和人的具有主体性的心智在主宰。当然,一旦弈棋的算法确定了,它的运行过程还是自动的。

摘 | 蓝天蒙

本文摘编自《智能与智慧——人工智能遇见中国哲学家》(宋冰/编著,中信出版社,2020年2月)。原题为“人类意识与机器意识的演化”,有删节。

(版权所有,未经允许请勿转载)

编者注: 刘晓力老师提到的文章载于《光明日报》2016年05月25日14版,题为《如何理解人工智能》,文章提到“AlphaGo是一个人机交互的巨无霸耦合体,是一个即时处理专项任务的延展认知系统,这个系统的核心是人。前台表演的只是这个系统的程序运行终端,而人才是其背后的智力资源。”